Это наборы данных, которые быстро генерируются и поступают из разных источников.

Термин «большие данные» появился в 2008 году, когда редактор журнала Nature Клиффорд Линч заявил, что объем информации в мире растет слишком быстро. До 2011 года термин Big Data использовали только в науке и статистике. С 2014 года собирать и анализировать данные начали ведущие вузы мира и IT-гиганты: IBM, Google, Microsoft.

Что такое Big Data

Большие данные — это массивный объем структурированной, полуструктурированной и неструктурированной информации. К Big Data относятся технологии, которые собирают и обрабатывают данные:

- сообщения из соцсетей;

- статистика подсчета посетителей интернет-магазинов и других сайтов;

- спутниковые снимки;

- стриминговые аудио- и видеопотоки;

- банковские транзакции;

- содержимое веб-страниц и мобильных приложений;

- телеметрию — показания с автомобилей и мобильных устройств;

- данные финансового рынка.

То есть это практически вся информация, что есть в мире.

Технологические компании практически никогда не удаляют информацию, которую собрала система: ведь завтра она будет стоить дороже, чем вчера. Даже в первых версиях систем хранения больших данных не было команды «Удалить данные».

Работать с данными учат в онлайн-университете Skypro на курсе «Аналитик данных». Опытные преподаватели расскажут и покажут, где взять информацию, как отфильтровать только нужные цифры, провести анализ и представить результаты работы в виде графиков и диаграмм. Освоите статистику и теории вероятностей, чтобы строить гипотезы и проверять их на основе больших данных.

Преимущества технологии

Технологии, которые появились за последние десять-двенадцать лет, сделали Big Data важным инструментом для бизнеса. Теперь у компаний есть доступ к огромным объемам информации, которая поступает из разных источников: социальных сетей, онлайн-покупок, датчиков и многих других. Эти сведения помогают принимать более точные и обоснованные решения.

Например, раньше менеджеры анализировали продажи прошлого года и проводили опрос клиентов, чтобы понять, что им нужно. С большими данными сразу видно, какие товары покупают чаще, что дольше лежит на полках и о чём говорят в соцсетях. Это помогает лучше понять клиентов и предложить им, что они хотят. А еще Big Data улучшают работу внутри компании. Например, помогают узнать, где на производстве есть задержки или ненужные траты. Это сокращает расходы и делает работу быстрее и лучше.

Еще большие данные «предсказывают» будущее. На основе старых сведений компании заранее понимают, какие товары будут востребованы, и подготавливаются к изменениям на рынке. Это особенно важно при высокой конкуренции. Big Data улучшают качество обслуживания клиентов. Если компания знает, что нужно людям, она предлагает подходящие товары. Тогда клиенты довольны и чаще возвращаются за покупками.

Где применяют: примеры использования Big Data

Big data полезны в разных сферах. Вот несколько примеров.

- Медицина

Анализ больших данных помогает врачам ставить точные диагнозы, прогнозировать развитие болезней и подбирать индивидуальное лечение. Умные часы фиксируют пульс и уровень кислорода в крови. Если показатели резко ухудшаются, система предупреждает человека о возможных рисках. - Маркетинг и реклама

Компании анализируют поведение клиентов в интернете и предлагают товары, которые им интересны. Например, если человек искал в интернете кроссовки, то в течение дня он будет видеть рекламу этих кроссовок или похожих моделей на разных сайтах и в соцсетях.

Приложения и сервисы для автоматического анализа создают разработчики. Этому можно научиться в онлайн-университете Skypro на курсе «Веб-разработчик». За двенадцать месяцев освоите основные инструменты и закрепите знания на практике. Это реальные проекты от будущих работодателей, которые потом можно положить в портфолио.

- Финансовый сектор (банки и страхование)

Big Data помогают банкам выявлять мошенников, оценивать кредитоспособность клиентов и предлагать персональные финансовые продукты. Если система заметит, что с карты клиента в один день снимают деньги в разных странах, программа автоматически заблокирует карту и предупредит банк о возможном мошенничестве. - Логистика и транспорт

Компании используют анализ данных, чтобы настроить маршруты, предсказывать задержки и экономить на перевозках. Например, Uber анализирует данные о пробках и автоматически меняет стоимость поездки: если много заказов и мало машин, цена растет. А авиакомпании прогнозируют спрос на билеты и меняют цены в зависимости от сезона и загруженности рейсов. - Госуправление и безопасность

Big Data используют, чтобы управлять городами, анализировать преступность и предсказывать катастрофы. Видеокамеры с ИИ в городах находят преступников — сканируют лица прохожих. Анализ данных о погоде и геологических процессах сообщает о землетрясениях и цунами.

Кто работает с большими данными

С Big Data работают разные специалисты.

- Инженер данных. Специалист собирает, обрабатывает и хранит данные. А еще работает с разными базами данных и высоконагруженными системами обработки. Инженер настраивает базу, которая собирает информацию о покупках в интернет-магазине.

- Дата-сайентист. Использует статистику и машинное обучение — так специалист создает модели, которые предсказывают будущее. Например, на основе данных о прошлых продажах прогнозирует, какие товары будут популярны в следующем сезоне.

- Аналитик данных. Изучает данные, чтобы найти закономерности и сделать выводы. Специалист компании Netflix изучает, какие фильмы и сериалы популярны. На основе этих отчетов сервис предлагает пользователям персональные рекомендации.

- Специалист по машинному обучению. Разрабатывает алгоритмы, которые обучаются на данных, делают прогнозы или принимают решения. Например, такие специалисты создают модели, которые распознают изображения.

- Бизнес-аналитик. Помогает компаниям принимать решения на основе данных. Специалист использует данные о клиентах — так он сможет предложить им новые продукты или изменить стратегию маркетинга.

Характеристики больших данных

У Big Data есть несколько ключевых характеристик, которые отличаются от традиционных данных. Эти характеристики часто обозначают как «4 V».

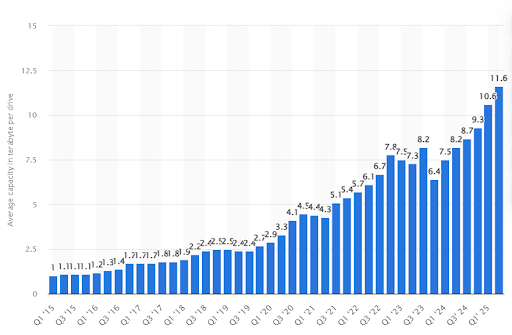

Volume (объем). Согласно статистике, во втором квартале 2025 года средний размер жесткого диска (HDD) от Seagate составил примерно 11,6 терабайта. Это больше, чем в предыдущем квартале, когда средний объем был 10,6 терабайта.

Источник: translated.turbopages.org

Velocity (скорость). Описывает, как быстро накапливаются данные. Эту характеристику определяют два фактора:

- Скорость накопления от одного источника данных. Например, соцсеть сохраняет информацию о том, сколько раз один пользователь открывал страницу у себя на компьютере или в приложении на смартфоне. Информация обновляется по несколько раз в день.

- Количество источников данных. Например, в социальных сетях миллионы пользователей по всему миру. Если собирать информацию о каждом посетителе, то скорость накопления — это миллионы записей в секунду.

Variety (разнообразие). Данные отличаются по типу. Они бывают:

- Структурированные — это строго организованные данные. Например, данные о студентах какого-либо онлайн-курса хранятся в базе данных в виде таблицы с информацией: имя, возраст, пол, адрес и номер телефона.

- Полуструктурированные — это так называемые интернет-данные. Например, профили пользователей соцсетей: они могут менять информацию в профиле так часто, как захотят. Это значит, что информация оттуда слабо структурирована.

- Неструктурированные — тип файла известен, а содержание нет. Таких файлов нет в базах данных и поэтому их трудно проанализировать. Например, презентации, видео, тексты или изображения.

Veracity (достоверность). Это значит, что данные точные, им можно доверять, анализировать и использовать, чтобы принимать бизнес-решения. Точность данных особенно важна в финансовых организациях. Даже одно неверно записанное число и отчет будет неправильным. Но иногда точность не так важна. Например, когда данные копируются со скоростью больше тысячи записей в секунду, то ошибка в одной или десяти записях не критична, потому что остальные 900 — правильные.

Классификации данных

Классификации больших данных помогают лучше понять, какие есть типы данных и как с ними работать. Основные категории Big Data можно разделить на несколько видов:

По типу данных

- Структурированные: легко вписываются в таблицы и базы данных. Это, например, информация о клиентах: имя, фамилия, адрес в табличной форме.

- Полуструктурированные: у них не такая строгая структура, как у структурированных данных. Например, XML- или JSON-файлы, где информация организована не в форме таблицы.

- Неструктурированные: здесь нет четкой структуры. Например, текстовые документы, электронные письма, изображения, видео- и аудиофайлы.

По источнику данных

- Сгенерированные пользователями: то, что создал человек — сообщения в соцсетях, обзоры продуктов и комментарии на сайтах.

- Данные сенсоров: информация из разных датчиков или устройств. Например, параметры температуры с метеостанций или информация о движении автомобилей.

- Из интернета: данные с веб-сайтов, новостных лент и других онлайн-ресурсов. Например, информация о трафике на сайте или статистика продаж из интернет-магазинов.

По времени жизни данных

- В реальном времени: информация, которая обрабатывается и анализируется сразу, как появилась. Например, сведения о транзакциях в банке нужно проверять очень быстро.

- Прошлые: можно хранить и анализировать позже. Например, финансовые отчеты за прошлые годы.

По размеру

- Маленькие: обычно не больше нескольких гигабайт. Например, данные небольшого исследования.

- Большие: слишком объемная или сложная информация, которую не обработать традиционными методами. Это терабайты или даже петабайты данных. Например, сколько пользователей заходило на сайт за последние пять лет.

Источники больших данных

Данные помогают компаниям лучше понимать своих клиентов и улучшать сервисы. Есть три основные группы данных.

- Социальные. Поступают с веб-сайтов, из соцсетей, мобильных приложений и сервисов, интегрированных с социальными сетями. В социальных данных есть истории посещений, реакции на сообщения, новости и другие действия пользователей.

- Машинные. Данные, которые оборудование производит о самом себе. Информация о местоположении, внутреннем состоянии оборудования, например его температуре.

- Транзакционные. Это банковские или любые другие финансовые транзакции. Когда появились необанки — финтех-компании, которые оказывают услуги только через приложение или сайт, без физической точки, количество транзакционных данных в мире резко выросло.

Где хранят и как обрабатывают Big Data

Big Data хранятся в дата-центрах с мощными серверами. Это распределительные системы хранения — если данные не помещаются на одном сервере, их нужно разделить на несколько. Когда записи разбиты на части, информация обрабатывается быстрее, так как над каждой частью работает отдельный сервер и процессы обработки идут параллельно.

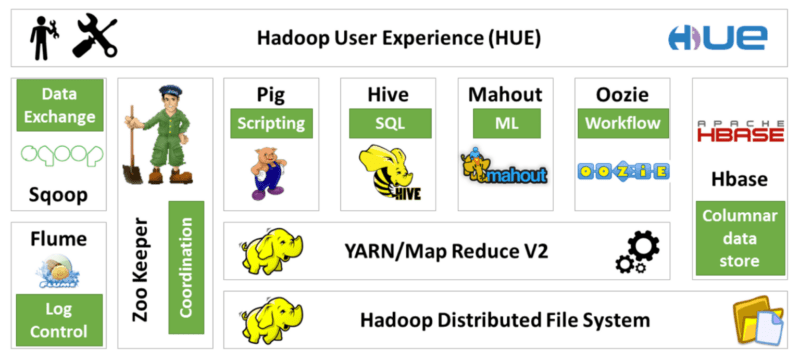

Одна из самых популярных систем для сбора и хранения данных — Hadoop. Есть даже серия других систем хранения, которые работают на базе Hadoop. В них можно добавлять новые функции, которых нет в стандартной версии приложения. Например, управлять вводом и хранить большие наборы записей для анализа и машинного обучения.

Источник: sky.pro

Методы анализа Big Data

Для анализа можно использовать любые объемы больших данных.

Описательная аналитика. Цель — ответить на вопрос «Что случилось?». Описательная аналитика изучает прошлые данные и помогает понять общие тенденции, закономерности и поведение. Это самая простая форма анализа, но она важна, так как служит основой для более сложных видов аналитики. Например, руководство интернет-магазина анализирует данные о продажах за прошлый месяц и видит, что в праздничные дни продажи резко выросли.

Диагностическая аналитика. На этом этапе возникает другой вопрос: «Почему это случилось?». Диагностическая аналитика глубже исследует данные, чтобы найти причины событий. Здесь используется сравнение, корреляции и анализ аномалий. Менеджер интернет-магазина выясняет, почему продажи выросли в праздники. Оказывается, запуск рекламной кампании совпал с этим периодом.

Прогнозная аналитика. Отвечает на вопрос «Что случится в будущем?». Прогнозная аналитика использует статистические модели и машинное обучение, чтобы предсказать будущие события на основе прошлых данных. Так можно узнать, например, какие товары будут популярны в следующем месяце.

Предписательная аналитика. Это самый сложный и продвинутый метод. Отвечает на вопрос «Как поступить?». Такая аналитика предсказывает будущее и предлагает оптимальные решения. Использует ИИ, оптимизационные алгоритмы и сценарный анализ. На основе прогнозов система интернет-магазина автоматически регулирует цены и заказывает дополнительные товары, чтобы не было дефицита.

На курсе «Аналитик данных» от Skypro обучают разным методам анализа. А еще освоите SQL и Python, чтобы создавать классные графики и диаграммы — данные туда будут подтягиваться автоматически.

Языки программирования для работы с большими данными

У каждого языка свои особенности, и какой выбрать — зависит от требований проекта и специфики работы с данными.

- Python

Python — это один из самых популярных языков программирования для работы с большими данными. Такой язык просто изучать и у него много библиотек, например Pandas, NumPy и Matplotlib. Например, нужно проанализировать данные о продажах интернет-магазина. На Python легко загрузить данные, отфильтровать их, подсчитать средние значения и сделать график с результатами.Источник: aiit-sa.co.za

- R

R — специальный язык для статистики и анализа данных. Его часто используют в научных исследованиях и аналитике. На R можно выполнять сложные статистические тесты, строить модели и создавать красивые графики — визуализировать результаты. Например, построить диаграмму, которая показывает, как физические упражнения влияют на уровень холестерина пациентов. - Java

Java часто используют, чтобы обрабатывать большие данные. Это надежный язык, и он хорошо подходит для многопоточной обработки. В крупных компаниях с массивами данных Java используют, чтобы создавать приложения, которые обрабатывают информацию в реальном времени. В системах анализа логов, например Hadoop, Java распределяет процессы и обрабатывает данные, которые хранятся на нескольких серверах.Источник: habr.com

- SQL

На языке SQL (Structured Query Language) можно извлекать, добавлять, менять и удалять информацию в реляционных базах данных. Например, есть база данных с информацией о клиентах. Если нужно узнать, сколько клиентов сделали покупки в прошлом месяце, то можно написать запрос на SQL. И база данных выдаст список всех клиентов, которые сделали покупки, и посчитает их количество. - Julia

Julia — это относительно новый язык, он становится всё более популярным. Julia быстрый язык, хорошо подходит тем, кто работает с большими объемами данных и сложными вычислениями. Если работаете с научными записями и у вас большой массив чисел, то можно написать программу на Julia, которая быстро всё посчитает и выдаст результаты.Источник: www.aiplusinfo.com

Как создать эффективную стратегию по работе с Big Data

Есть два подхода к разработке стратегии: проактивный и реактивный.

Реактивный — это реакция на события после их возникновения. Изначально компании так и делали: собирали все данные, а потом решали, что с ними делать.

Проактивный — это когда события прогнозируют заранее и готовятся к ним. Этот подход сложнее, потому что прогнозы не всегда точные, но эффективнее.

Сначала компании просто собирали данные и не понимали, какие из них нужны. С развитием технологий данные решают конкретные задачи. Например, чтобы спрогнозировать поломку оборудования, первым делом учитывали только его характеристики. Но потом стало понятно, что важны и другие факторы: сколько сотрудников работает на установке, как долго и какой у них опыт.

Проактивный подход лучше. Он помогает заранее найти проблемы и решить их. Например, увеличить выпуск продукции при тех же ресурсах, снизить аварийность или сократить затраты. Эффективная работа с большими данными — это проактивная стратегия, которая встроена в бизнес и помогает решать конкретные задачи.

Сложности применения Big Data

Big Data дает большие возможности, но придется справиться с некоторыми сложностями.

- Чтобы хранить большие данные нужна мощная инфраструктура — специальные дата-центры (ЦОД). Но они дорогие и требуют больших вложений.

- Создать аналитическую модель потребуется много времени. Например, чтобы обучить нейросеть генерировать изображения по описанию, нужно 270 терабайт данных и около недели на обучение.

- Важно не только разбираться в технологиях, как обрабатывать данные, но и понимать, где и зачем их применять. Немного сложнее определить, что именно нужно анализировать, чем просто настроить систему.

Перспективы развития Big Data в России и мире

Сейчас интерес к большим данным стал меньше, потому что много компаний уже работают с этой технологией и получают реальные результаты.

В России уровень цифровизации высокий и технологии больших данных продолжат развиваться в разных сферах: социальной и государственной. Прогнозируется, что будет не хватать специалистов в этой области (по разным оценкам, дефицит будет составлять на 25–35%).

Крупные компании, например «Газпром», «Транснефть», ВТБ и «Ростелеком», активно используют большие данные и разрабатывают новые технологии. Но у них нет бюджетов на то, чтобы создавать собственные центры обработки данных. Поэтому в будущем технологии станут дешевле и будут доступны не только большим корпорациям.

С развитием облачных технологий появляются новые государственные сервисы. Например, в Москве для малого и среднего бизнеса уже есть онлайн-сервисы: «Подбор городских помещений для бизнеса», «Подбор рыночной ниши» и «Готовые помещения под франшизу». Город собирает много данных о гражданах, их перемещениях и предпочтениях. Эту информацию можно использовать, чтобы улучшить городскую инфраструктуру. В будущем таких сервисов станет еще больше.

Коротко о технологии Big Data

- Большие данные — это наборы информации, которая быстро генерируется и поступает из разных источников. Big Data можно использовать, чтобы составлять прогнозы, статистику и принимать бизнес-решения.

- С Big Data работают инженеры, аналитики, специалисты по машинному обучению, бизнес-аналитики.

- Большие данные используют в бизнесе, банковской сфере, маркетинге, госструктурах, логистике, медицине.

- Есть четыре основные характеристики больших данных: объем, скорость накопления данных, разнообразие, достоверность.

- Большие данные делятся по типу и источнику данных, размеру и по времени жизни данных.

- Данные в основном поступают из трех источников: социальных — это соцсети, приложения, онлайн-сервисы; машинных — оборудование, элементы умного дома; транзакционных — финансовые транзакции.

- Данные хранятся в дата-центрах с мощными серверами. Обрабатывают данные в распределенных системах хранения данных.

- Для анализа Big Data используют описательную, диагностическую, прогнозную и предписательную аналитику.

- У Big Data большие перспективы, но есть и сложности: для хранения данных нужна инфраструктура, которая стоит дорого. Еще, чтобы работать с большими данными, надо хорошо разбираться в нише, где их применяют, а не только в технической части.

Перейти в телеграм, чтобы получить результаты теста

Перейти в телеграм, чтобы получить результаты теста

Добавить комментарий