A/B-тестирование что это

Возможно, вы сталкивались с такой ситуацией: в голову пришла идея, которая может улучшить метрики, увеличить количество пользователей или клиентов, а потом в голову закралась мысль — а вдруг всё станет хуже?

В таких случаях помогут A/B-тесты.

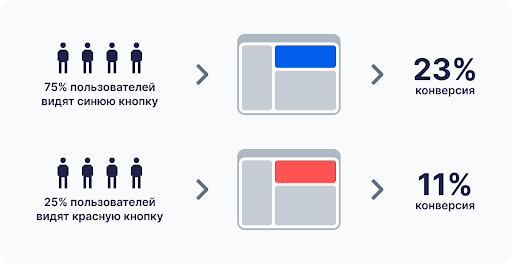

Пример A/B-теста с изменением цвета элемента

Например, вы делаете промостраницу мероприятия и хотите повысить конверсию. Дизайнер предлагает: «Давайте сделаем кнопку регистрации поярче». Идея неплохая, но хочется ее проверить, чтобы не отпугнуть всех тех гостей, которых привлекал старый вариант страницы.

A/B-тесты — инструмент, который помогает провести такую проверку, выбрать, как дальше развивать продукт и при этом не растерять всех клиентов во время экспериментов.

Какие задачи решает

Итак, вы хотите сделать кнопку ярче, но боитесь ухудшить конверсию. Тогда вы берете 15% посетителей и показываете им ярко-красную кнопку, а остальные 85% видят привычный вариант. Потом аналитики сравнивают, у какого варианта процент конверсии лучше.

Если конверсия падает, значит, что-то пошло не так. Например, красный цвет «слился» с фоном, пользователи перестали замечать кнопку. А если число регистраций выросло, значит, пользователи стали чаще обращать на нее внимание.

Кому необходимо

A/B-тесты особенно полезны, когда уже есть аудитория. Чем больше аудитория, тем выше риск оттолкнуть уже лояльных пользователей. Поэтому продукт лучше менять постепенно и показывать каждое новое изменение только части пользователей.

Если же вы запускаете новый проект или стартап, лояльной аудитории нет, отталкивать некого. Тогда можно проводить более смелые эксперименты и не тратить время на A/B-тесты.

Основные виды

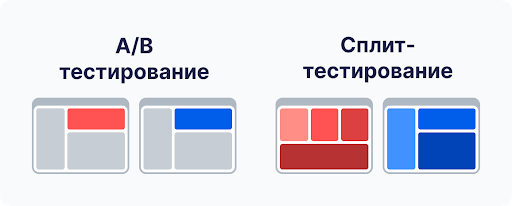

Помимо классического A/B-тестирования, есть еще несколько похожих методов.

Сплит-тестирование (Split Testing). При сплит-тестировании запускают отдельную веб-страницу или экран мобильного приложения, где нужна совсем другая верстка. Другими словами, проверяют большие изменения, например полный редизайн.

Сплит-тестирование часто путают с A/B-тестированием, но это разные процессы. В отличие от сплит-тестов, A/B-тесты последовательно проверяют небольшие изменения. Например, сначала меняют цвет кнопки, смотрят, стало ли лучше, а потом переходят к другим элементам.

Мультивариативное тестирование (Multivariate Testing, MVT). Оно помогает проверить сразу несколько небольших изменений. На каждую уникальную комбинацию доработок направляют часть аудитории.

В примере с кнопкой регистрации на странице можно изменить не только цвет, но и расположение. Составьте все возможные комбинации:

- «Базовый» вариант: оставляем прежний цвет и расположение.

- Вариант А: делаем кнопку красной, но позицию не меняем.

- Вариант Б: сохраняем цвет, но переносим кнопку в левый угол.

- Вариант В: делаем кнопку красной и ставим в левый угол.

Каждому варианту нужно выделить по 25% аудитории, а потом посмотреть, где зарегистрировалось больше людей.

Пример MVT-теста, где тестируют комбинацию изменений (цвет/расположение)

Мультистраничное тестирование (Multipage Testing). Им проверяют один и тот же элемент на всех страницах, где он есть.

Например, в разных частях сайта есть одна и та же кнопка регистрации. Вы хотите перекрасить ее на всём сайте. Проверки конверсии этой кнопки у новых пользователей на главной странице недостаточно: возможно, на главной странице решение перекрасить кнопку было удачным, но что насчет всех остальных страниц, где еще появляется эта кнопка? Где-то конверсия могла и упасть.

Поэтому проанализировать нужно все страницы, где есть кнопка регистрации.

Хотите разрабатывать гипотезы, собирать и интерпретировать результаты A/B-тестов? В курсе Skypro «Аналитик данных» вы научитесь проводить такие эксперименты, визуализировать итоги и аргументированно представлять их коллегам и руководителям.

Пример мультистраничного теста, где мы должны проверить конверсию на каждой затронутой странице

Инструменты

Сейчас есть много сервисов для A/B-тестов.

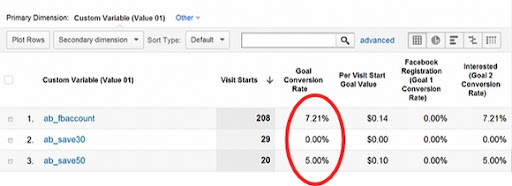

Google Analytics. Это один из самых популярных сервисов для маркетологов и аналитиков. В нём легко настроить тесты прямо на сайте и отследить ключевые конверсии. За A/B-тестирование здесь не нужно доплачивать.

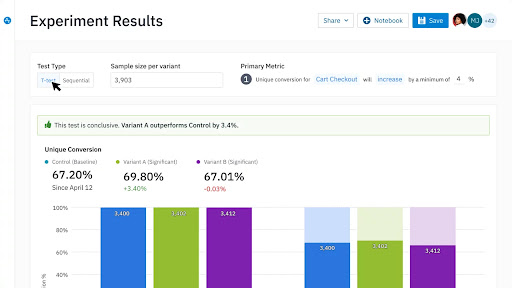

Результаты A/B-тестирования в Google Analytics

В Google Analytics можно посмотреть, как пользователи реагируют на разные варианты сайта. Можно задать ключевые метрики, и сервис покажет результаты по каждому тесту. Минус в том, что A/B-тесты тут работают только для веба, а не для мобильных приложений.

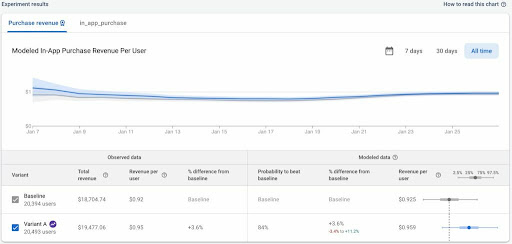

Сервис Firebase. Он нацелен на продуктовые решения: мобильные и веб-приложения. Как и в Google Analytics, здесь можно настроить ключевые метрики и выбрать, кто именно увидит каждый вариант. Зато в информационных сайтах Firebase может быть не так полезен. При этом инструменты A/B-тестирования в нём тоже бесплатные.

Результаты тестирования в Firebase Analytics

Amplitude Experiments. Удобный сервис, который тесно связан с Amplitude Analytics и удобен для продуктовой разработки. Для тестирования информационных сайтов или порталов сервис перегружен функциями, за которые всё равно нужно платить — так что лучше использовать бесплатные сервисы выше.

Результаты тестирования в Amplitude Experiments

Если не уверены, какой инструмент лучше использовать, или еще не работали в сфере аналитики, то в Skypro есть обучение по профессии «Аналитик данных».

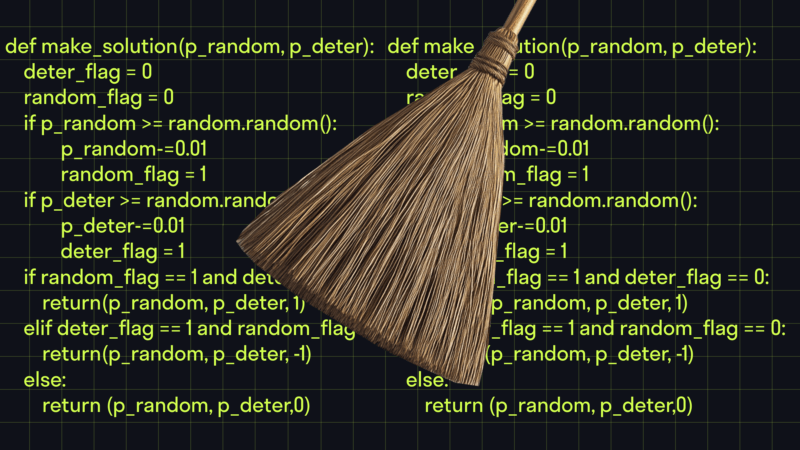

А/B тестирование и анализ данных в Python // Урок 6 от Skypro

Что нужно тестировать

Тестируйте любые изменения, которые влияют на целевые действия пользователя — регистрацию, покупку, заявку и так далее.

Например, тестировать надо обязательно:

- если вы делаете редизайн сайта, страницы или ее элемента;

- добавляете новые или удаляете функции с сайта: формы, кнопки, фильтрацию.

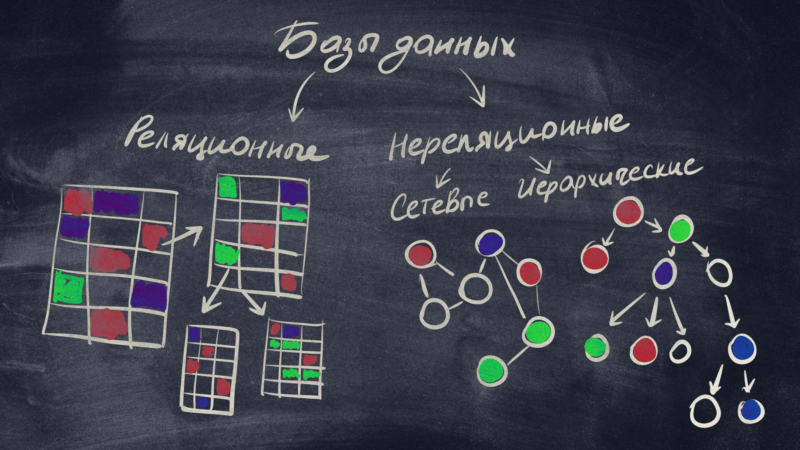

Если изменения касаются исключительно «внутренней работы сайта», то тестировать не нужно. Например, переносите базу данных с одного сервера на другой. Это важное изменение для вас, но пользователи о нём даже не узнают.

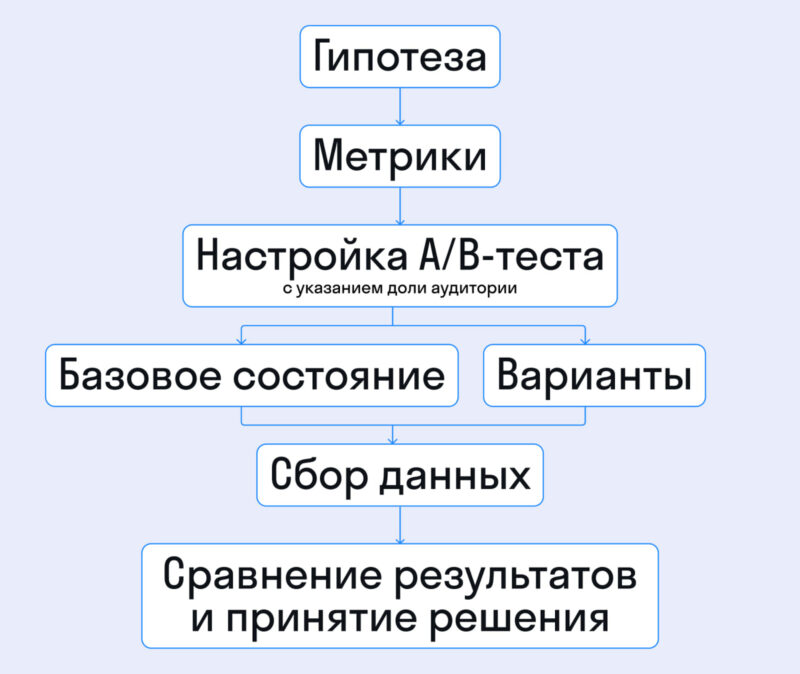

Как провести A/B-тестирование

Начинайте любой A/B-тест с гипотезы — идеи о том, как улучшить сайт или приложение. Если кажется, что она слишком большая, разбейте ее на несколько маленьких. Например, вы думаете, что дизайн сайта слишком блеклый. Прежде чем раскрашивать сайт, сделайте варианты с разными версиями акцентных цветов. Возможно, на самом деле цветовая гамма всех устраивает.

Когда определились с гипотезой, подключите метрики, которые помогут отследить нужные показатели. Например, если хотите повысить переходы на форму регистрации, настройте счетчик именно на эти переходы.

Потом воспользуйтесь любым внешним сервисом, чтобы создать новый A/B-тест. Укажите, какую часть аудитории затронет эксперимент, и следите, выполняется ли ваша гипотеза.

Обычно при настройке A/B-теста указывают базовое состояние. Это значит, что для части пользователей всё остается по-прежнему. Потом добавляете столько вариантов, сколько нужно.

- В классическом A/B-тесте обычно два варианта: «Базовый» и, например, «Красная кнопка регистрации». В мультистраничном варианте этого теста сделайте такие же проверки на всех страницах, где есть кнопка регистрации.

- Если используете мультивариативный тест (MVT), можете добавить еще варианты: «Синяя кнопка», «Желтая кнопка» и так далее.

Для каждого варианта (кроме базового) настройте аудиторию, которая его увидит. Скажем, вы хотите поменять цвет кнопки регистрации у 10% пользователей, которые не зарегистрированы, живут в США и подходят под любые другие ваши критерии.

После того как запустили тест, дождитесь статистически значимых результатов. Время ожидания зависит от количества пользователей: если у вас мало посетителей, придется ждать, пока наберется достаточное количество данных.

Используйте калькуляторы A/B-тестов в интернете, чтобы понять, какой объем данных надо собрать. Многие сервисы (например, Evan Miller, Optimizely, VWO) помогают рассчитать нужный объем: вы указываете только базовую конверсию и желаемый эффект.

Не злоупотребляйте A/B-тестами. Каждый тест замедляет развитие продукта. Если уверены, что новая функция нужна пользователям (например, они давно просят ее добавить) и не усложните жизнь аудитории, запускайте сразу. Если что-то пойдет не так, всегда можно поправить или вернуть старую версию.

Как оценить результаты

Может оказаться, что базовая версия показала результаты выше, чем вариант с изменениями. Не спешите считать гипотезу провальной — сначала проверьте, кого включили в тест. Возможно, выбрали слишком маленький процент пользователей.

Тогда можно повысить процент тех, кто участвует, или облегчить критерии отбора: не искать сегмент «посетители старше тридцати лет, которые заходили на сайт более трех раз и хотя бы раз совершили покупку», а остановиться просто на «тех, кто заходил на сайт больше трех раз».

Иногда во время теста разница в показателях получается незначительной. В этом случае придумайте гипотезы, которые дополнят основную, и проведите дополнительные тесты.

Если хотите научиться формулировать гипотезы, создавать A/B-тесты и правильно читать их результаты, приходите на курс Skypro «Аналитик данных».

Частые ошибки

Самая распространенная ошибка в A/B-тестировании — слишком частое его использование. A/B-тесты нужны, чтобы не потерять уже лояльных клиентов или сегмент пользователей, которые и так стали бы вашими клиентами. Если использовать эти тесты постоянно, даже когда изменения вообще не связаны с действиями покупателей, то это лишь затормозит внедрение продукта.

Проводите тесты там, где важна конверсия: например, при регистрации или покупке. Или когда подозреваете, что нововведение может усложнять посетителям сайта или приложения работу с сервисом.

Еще одна частая проблема: тот, кто проводит тесты, не дожидается статистически значимого объема данных. Не делайте выводы, когда нововведение показали десяти посетителям и все они не ушли в конверсию — это нормально. Дождитесь, когда нововведение увидит хотя бы несколько сотен людей.

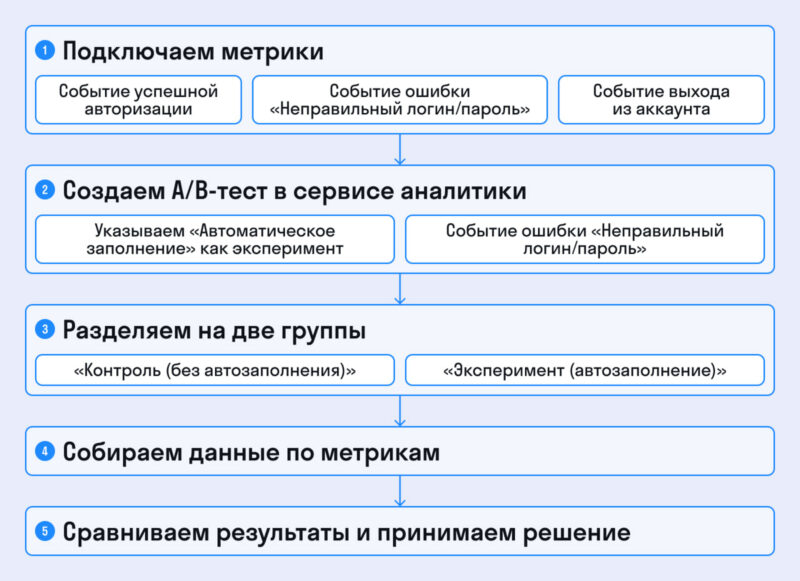

Пример A/B-теста

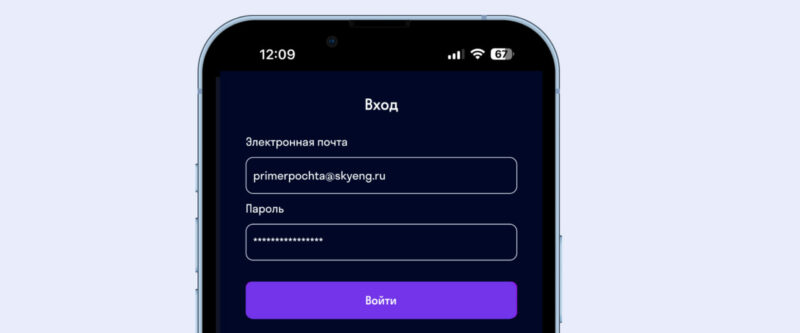

Представьте, что делаете мобильное приложение. Появилась идея: «Давайте автоматически подтягивать логин и пароль из браузера, чтобы пользователям не приходилось вспоминать свои данные».

Звучит удобно, но что если у человека несколько аккаунтов? Не запутаем ли мы его?

Формулируем гипотезу: «Если автоматически заполнять логин и пароль, то пользователям будет проще войти в приложение, а значит, конверсия в авторизацию вырастет».

Чтобы отследить эту конверсию, нужно добавить такие метрики:

- Событие успешной авторизации. Предполагаем, что с «автозаполнением» этот показатель вырастет.

- Событие авторизации с ошибкой «Неправильный логин/пароль». С помощью этой метрики проверяем, стало ли меньше неверных вводов.

- Событие выхода из аккаунта. Если пользователь вошел в чужой аккаунт, он сразу выйдет. Ждем, что количество таких выходов не увеличится.

- После того как подключили эти метрики, создайте A/B-тест в аналитическом сервисе. Укажите вариант «Автоматическое заполнение логина/пароля» и определите, какой процент аудитории участвует в эксперименте, например 50%.

Когда тест соберет данные, посмотрите на метрики. Если они изменились так, как мы ожидали, можно считать эксперимент успешным и включить автозаполнение для всех. Если результаты отличаются, стоит подкорректировать гипотезу и запустить новый тест.

Главное про A B тестирование

- A/B-тестирование помогает понять, как изменения в продукте влияют на метрики и конверсию. Часть аудитории видит новую версию, а остальные продолжают пользоваться старой.

- A/B-тестирование важно, если у вас уже есть лояльные пользователи. Резкие перемены могут их отпугнуть, поэтому лучше постепенно вводить изменения и показывать их только части пользователей.

- Вариантов тестирования несколько: классический A/B, мультивариативный и мультистраничный. Они отличаются масштабом изменений.

- Для экспериментов подойдут Google Analytics, Firebase и Amplitude. В них удобно выбрать, кто увидит новую версию, а еще отследить основные метрики.

- Перед запуском сформулируйте гипотезу и определите, по каким показателям будете судить об успехе. Так вы точно понимаете, что проверяете и когда эксперимент можно считать удачным.

- Оценивайте результаты, когда соберется достаточный объем данных. Если улучшений нет или эффект слишком маленький, пересмотрите гипотезу и попробуйте снова.

- Иногда A/B-тесты проводят слишком часто и тормозят развитие продукта. Не злоупотребляйте ими. Тесты нужны, когда вы сомневаетесь в гипотезе или хотите проверить ключевые действия.

- Следите за промежуточными показателями, чтобы вовремя заметить причину падения конверсии. Если данных не хватает, соберите дополнительные метрики и проанализируйте каждый шаг пользователя.

Перейти в телеграм, чтобы получить результаты теста

Перейти в телеграм, чтобы получить результаты теста

Добавить комментарий